Une longue pause nous a donné le temps de réfléchir bien avant de déposer notre script final sur le blogue et en même temps la deuxième partie de notre travail.

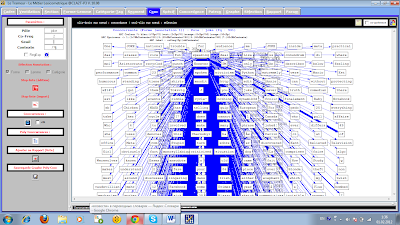

On a sauté les étapes où on aurait dû afficher notre travail avec les commandes egrep, iconv et lynx séparément sur le blogue ; en revanche on a pu finir le script complet incluant toutes les commandes étudiées. Effectivement, on a pris à la base le script existant déjà sur notre blogue où l’on avait utilisé la commande curl pour aspirer les pages des URLS. Après avoir pu ajouter plusieurs choses depuis un bon moment, on a obtenu quelque chose comme ça :

Dans les commentaires de notre script on peut retrouver l’information sur ce que l’on veut faire à chaque étape et quelle action chacune des commandes va accomplir.

Dans le Terminal on indique d’abord le répertoire où se trouvent les URLS en question. On donne le nom d’un fichier .html qui va contenir notre tableau définitif. En tant que motif on donne les mots sur lesquels on a travaillé : dans notre cas ce sont deux mots – blague et joke – puisque le mot joke est le même en anglais et en français québécois.

Voilà l’exécution du script sur le terminal :

On récupère chaque page .html sur l’ordinateur grâce à la commande curl ; puis la commande lynx -dump -nolist nous permet d’afficher le texte seul de l’URL sans références et on transforme l’encodage de la page en UTF8 avec la commande display_charset=$encodage. Ensuite, on utilise la commande egrep pour pouvoir retrouver le motif introduit, et pour effectivement le récupérer dans les dossiers DUMP-TEXTES et CONTEXTES.

Eh bien voilà notre tableau final :

Deuxième partie du projet

Les nuages de mots

On a créé les nuages de mots par le biais du site www.wordle.net. En insérant les fichiers .txt qui correspondent au contexte des mots sur lesquels on travaille (selon notre script ce sont les fichiers contexte1.txt, contexte2.txt et contexte3.txt situant dans le répertoire FICHIERGLOBAL) on a obtenu des nuages tout à fait diverses. Voilà, par exemple, le nuage pour le mot « blague » : … pour le « joke » en anglais :

… pour le « joke » en quebecois :

Et voilà ce qu’on a eu après avoir collé les trois fichiers à la fois :